MEGAZONEブログ

re:Invet2023 Day3 Dr. Swami Sivasubramanian 基調講演

Dr. Swami Sivasubramanian Keynote

Pulisher : MEGAZONECLOUD Tech Team Description : re:Invet2023 Day3 基調講演レポート

Keynoteレポートをはじめるにあたって

最近、生成型AI(Generative AI)の進化と機械学習及び人工知能の発展により、人間と技術間の相互作用がどのように革新と創造性を引き出すかについて話しています。 また、多くの企業は新しい方法で生産性と創造性を強化すると同時に、膨大な量の企業データをどのようにAIと一緒に活用するかを考えています。

2日目のメイン基調講演でも中心だった生成型AI及びデータについて、AWSのデータ及びAI担当Vice PresidentであるSwami Sivasubramanianがもう少し踏み込んだ内容で基調講演を行いました。

新たにリリースされた生成型AIサービスやデータに関するアップデートについて、本キノートレポートでお伝えします。

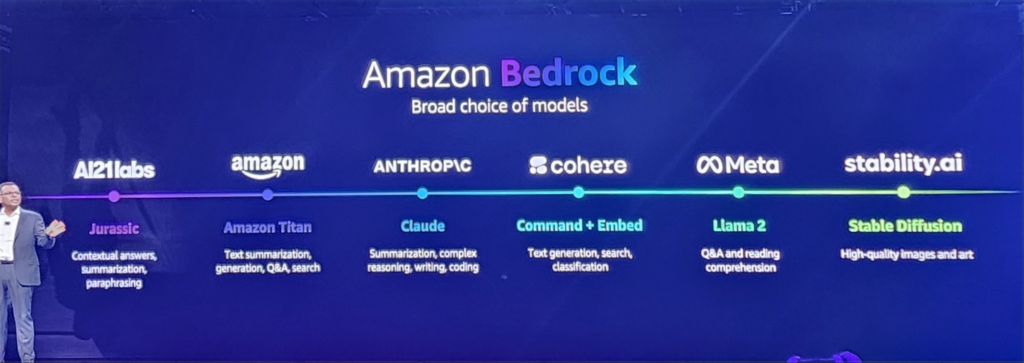

Amazon Bedrock : モデル選択範囲の拡大

Amazon Bedrockは、発売当初はTitanなど導入されたモデルの選択肢が少なかったものの、Lama 2 cohereなどを順次導入し、Bedrockを通じたモデルの選択肢の幅を広げています。

これにより、Amazon Bedrockは、業界をリードする大規模な言語モデルやその他のベースモデルの選択に簡単にアクセスできる完全管理型サービスとして、Gen AIへのアクセスをさらに身近なものにしました。

モデルの選択肢が多いということは、ユーザーがさまざまな状況や環境に適した、またはパフォーマンスやコストに最適化されたモデルを実験的に選択できることを意味し、より多くのユーザーが自分の環境に適したアプリケーション開発を加速することができるようになります。

Amazon Bedrock ANTHROP\C Claude 2.1

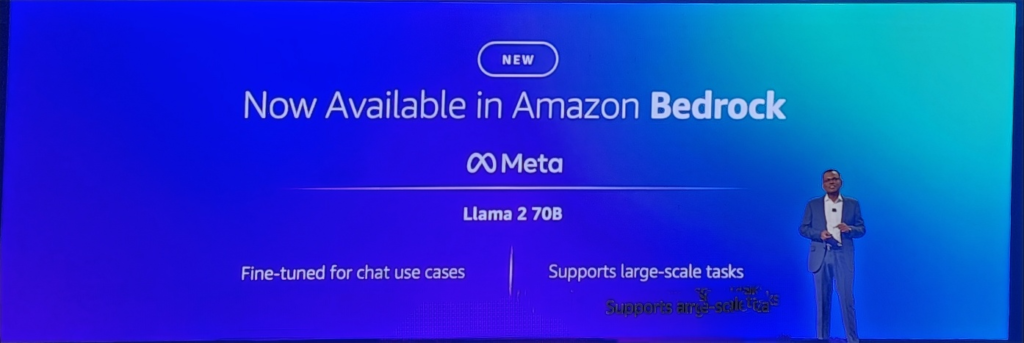

Amazon Bedrock Meta Llama 2 70B

Amazon BedrockでClaude 2.1モデルを使用できる機能をサポートしました。Claude 2.1は20万個に達するトークンをサポートすることで、より多くの数のテキストにアクセスして情報を確認し、要約して質疑応答や推論に対するより高い品質を保証します。

Llama 2はLlama 1と比較して40%より多くのデータを学習させたMetaの次世代モデルで、100万件以上の人との相互作用を通じた微調整(Fine-tuning)で最適化されています。

また、推論、コーディング、熟練度及び知識テストなどの部門において特に競争力のある性能を発揮します。

Amazon Titan Multimodal Embeddings

Multimodal Enbeddingsは、テキストや画像、または2つの組み合わせで入力された情報に基づいて、より正確で関連性の高い検索結果やレコメンドをサポートする機能です。

従来はテキストエンベッディングのみが可能でしたが、今回新たにマルチモーダルエンベッディングが可能になったことで、より正確で状況に合わせた検索とレコメンド環境を構築することができるようになりました。

・テキストと画像の統合:テキストと画像データを一緒に考慮し、より豊かで意味のある埋め込みを生成します。ユーザー自身のデータを活用して、産業やブランドに特化した画像を生成することができます。

・無害な画像生成 : 内蔵されたバイアスモニタリングにより、安全で倫理的な画像生成をサポートします。

・デジタルウォーターマーク:生成された画像に基本的に添付されるデジタルウォーターマークを通じてAI生成画像を識別し、改ざんを防止します。

このモデルは、画像と短いテキストを最大128トークンまでの埋め込みに変換し、データ間の意味と関係を捉えます。 また、画像のキャプションを細かく調整することができます。

これにより、正確で関連性のある画像検索を顧客に提供することができ、テキスト生成にも活用できるようになりました。

様々な産業全般にわたって多様に適用できることを期待しており、学習可能な実習から進めてその結果を確認したいと思います。

Amazon Titan Text Lite / Titan Text Express

埋め込みモデルをテキスト生成に活用できるAmazon Titan Text LiteとAmazon Titan Text Expressが発表されました。

Titan Text Liteは軽量サイズのテキストモデルで、費用対効果が高く、テキスト生成、会話システム、テキスト要約、および類似の作業に適したモデルです。

Titan Text Expressは、Titan Text Liteよりも広い範囲のテキスト生成タスクや様々なアプリケーションに適した高性能テキストモデルで、会話型チャット、オープンエンドの質問など、幅広いテキストベースの生成AIタスクを実行できるモデルです。

テキストに特化したAWSのGen AI技術で、エージェントなどの音声の領域をチャットボットの形で処理できるだけでなく、さらに技術に特化したQ&Aや専門的な領域まで答えてくれるモデルになると思います。実生活に深く入り込み、単純作業の領域を多くの部分で解決したり、問い合わせが可能なモデルとして、より多くの領域の多様な人々がアクセスする参入障壁をはるかに低くすることができると期待しています。

Amazon Titan Image Generator

最近、生成型AIの中でも画像生成が人気が高いですが、少ない費用で簡単に、正確に、そして社会的責任を果たすAmazon Titan Image Generatorを発表しました。

広告、オンラインマーケット、メディアおよびエンターテイメント分野の企業は、Amazon Titan Image Generatorを通じて、大量のスタジオで撮影したようなリアルな画像を低コストで制作することができます。高品質の様々なデータを通じて訓練され、高品質の画像を生成することができ、これを活用して有害なコンテンツの生成を減らすために、業界初のウォーターマークが挿入されて生成されます。

Titan Image Generatorはまだ開発中ですが、Bedrockを通じてAWSのお客様が使用することができます。開始するには、新しいBedrockプロジェクトを作成し、Titan Image Generatorモデルを選択した後、モデルにテキストの説明を提供すると、説明に合った画像を生成します。

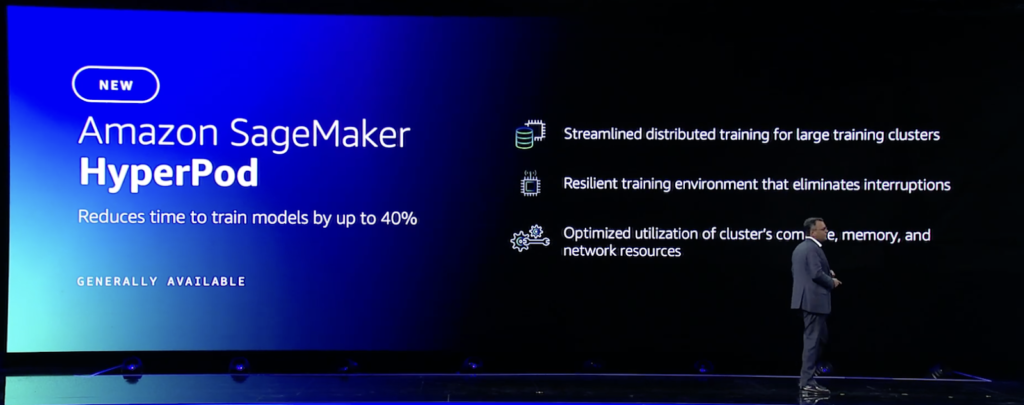

Amazon SageMaker HyperPod

Amazon SageMaker HyperPodは、大規模分散トレーニング用に特別に構築されたインフラを提供します。

数週間または数ヶ月間FMをトレーニングすることができ、HyperPodでモデルをトレーニングすることで、通常のSageMakerインフラストラクチャでトレーニングする場合と比較して、トレーニング時間を最大40%短縮することができます。

SageMakerは、クラスターの状態を積極的に監視し、障害が発生したノードを交換し、チェックポイントでモデルのトレーニングを再開することで、自動化されたノードとタスクの回復力を提供します。

さらに、クラスターには、トレーニングデータとモデルをすべてのノードに分割して並列処理し、クラスターのコンピューティングとネットワークインフラストラクチャを最大限に活用するのに役立つSageMakerの分散トレーニングライブラリがあらかじめ設定されています。

追加のフレームワーク、デバッグツール、最適化ライブラリをインストールすることで、トレーニング環境をさらにカスタマイズすることができます。

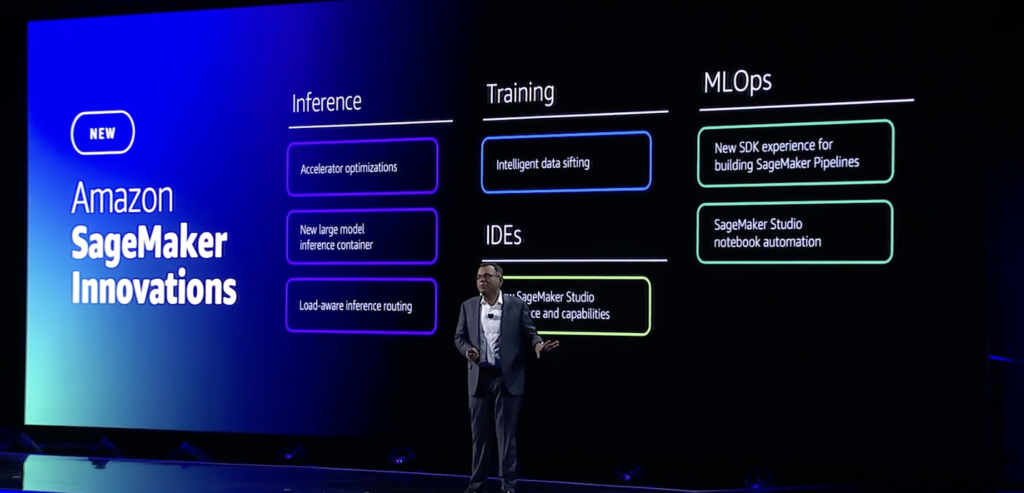

Amazon SageMaker Innovations

Amazon SageMaker Inferenceは、アクセラレータの使用を最適化することで、基礎モデルのデプロイメントコストを平均50%、レイテンシーを平均20%削減します。

Amazon SageMaker Clarifyにより、お客様は、AIの責任ある使用をサポートするパラメータに基づいて、基礎モデルをより簡単に評価・選択できるようになりました。

また、「Amazon SageMaker Canvas」機能により、お客様は数回クリックするだけで、自然言語の指示を使用してデータ準備を加速し、基礎モデルを使用してモデルを構築することができます。

今回の新規追加されたSagemaker機能により、基礎モデルのトレーニングにかかる時間を節約し、より優れた復元力を備えた形でアップグレードされることで、Sagemakerへの関心と導入がさらに高まるものと思われます。

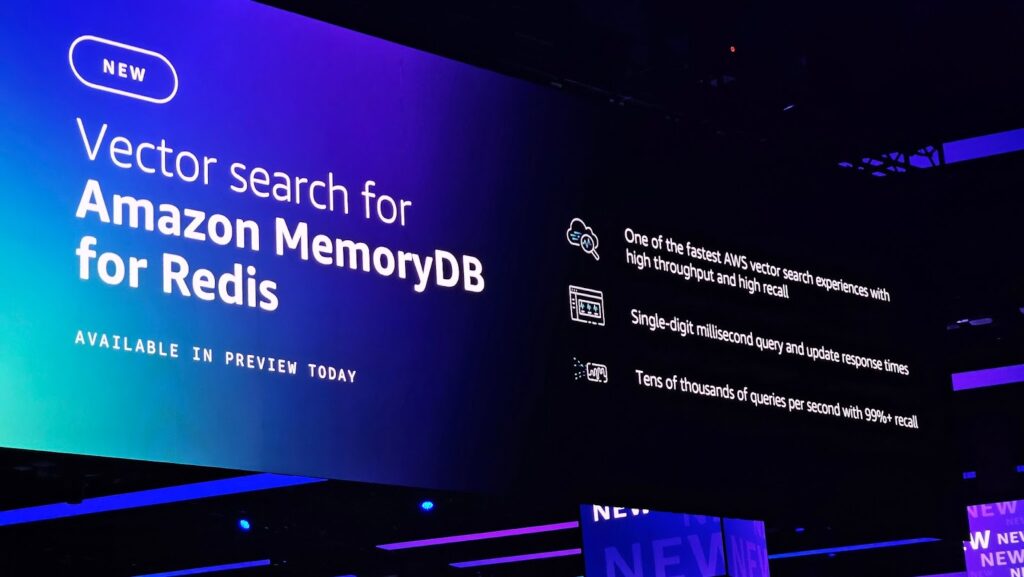

Vector engine for OpenSearch Serverless / Vector search for Amazon MemoryDB for Redis

Vector Searchは、超巨大言語モデル(LLM)を活用したアプリケーション開発において、多次元検索を可能にする必須要素とされています。

OpenSearch Serverlessを通じてベクターエンジンを使用すると、このようなベクターDBをインフラに対する構成や管理なしにMLベースの拡張検索環境を活用することができ、簡単にGen AIアプリケーションを構築することができます。

また、ベクターエンジンを使用すると、同じクエリでベクター検索とテキスト検索を組み合わせてハイブリッド検索で結果を調整し、最適化することができるため、別のストレージを活用する複雑な構造のアーキテクチャを構成する必要がありません。

Vector search for Amazon MemoryDBは数百万個のベクトルを保存し、99%以上の検索精度で一桁ミリ秒のクエリおよび更新応答時間と数万クエリ/秒(QPS)をサポートします。

BedrockやSageMakerなどのAI/MLサービスを使用してベクトル埋め込みを作成し、MemoryDB内に保存することができます。リアルタイム性 chatbotのようなGen AIを活用したアプリケーションは速度が非常に重要な要素であるため、これを活用して迅速にユーザーに応答を提供することができます。

Amazon Neptune Analytics

Amazon Neptune Analyticsは、大量のグラフデータをより速く分析できるように支援する分析データベースエンジンで、グラフデータを通じて多様なデータドメイン内の複雑な関係と接続を表現して分析できるため、ユーザーがより速く分析できる機能を提供します。

グラフデータの分析を行うためには、全体グラフをメモリにロードする必要がある場合が多いです。 そのため、一般的なグラフアルゴリズムによるグラフデータセットの分析を行うためには、特別なツールが必要でした。

Amazon Neptune Analyticsは、このような困難と不便さを解決するために完全管理型のグラフデータ分析環境を提供し、グラフサイズに応じてコンピューティングリソースを自動的に割り当て、すべてのデータをメモリに素早くロードして数秒でクエリを実行することができます。

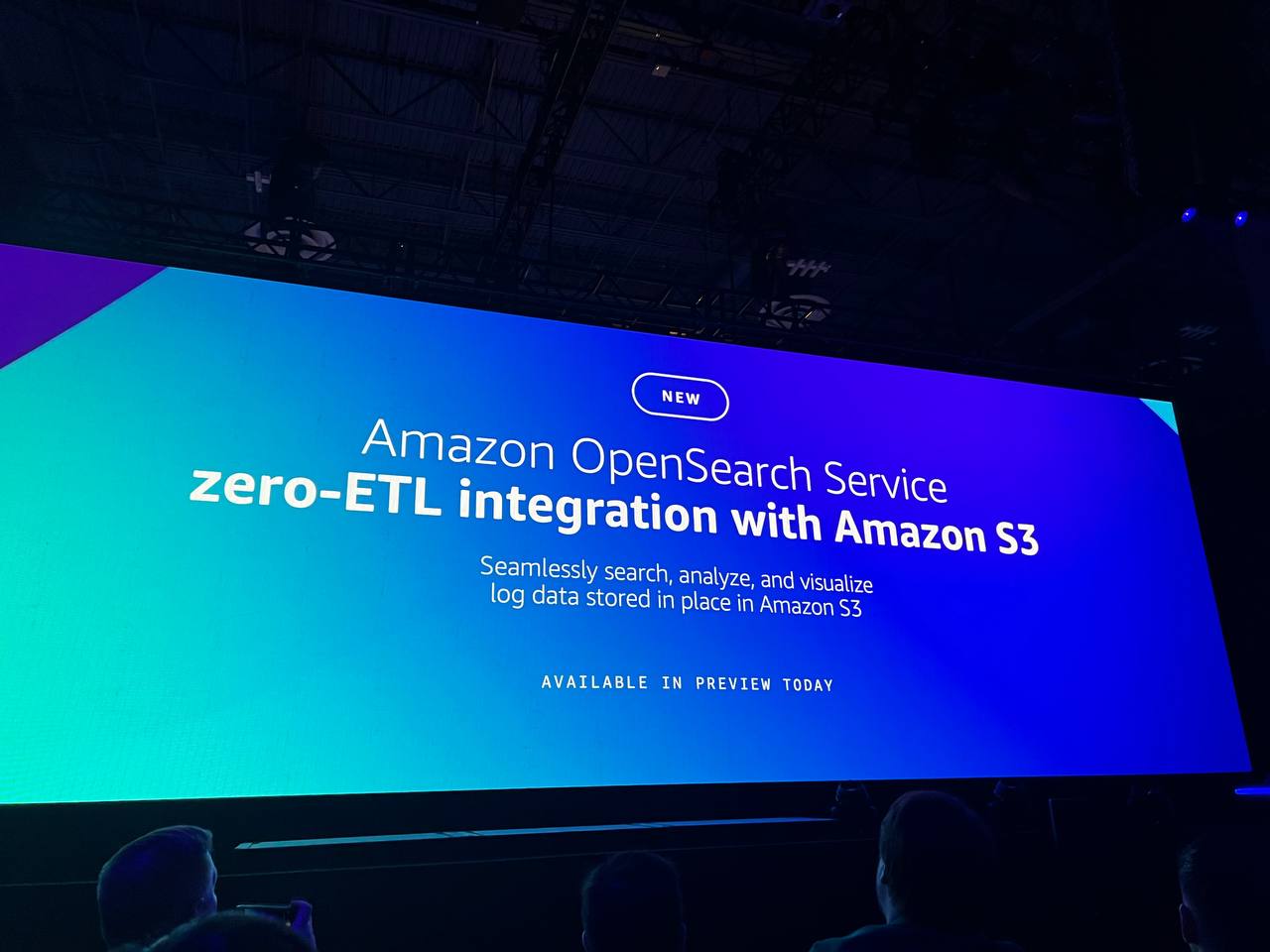

Amazon OpenSearch Service zero-ETL integration with Amazon S3

OpenSearchは一般的に非常に少量または特定の期間のデータを保管する場合が多いです。

これはOpensearch自体が検索する上で非常に速いという長所を持っていますが、検索を速くするためにデータを重複して保存する構造を持っているからです。

しかし、このようにデータを管理しても、ある時点では過去のデータもOpenSearchに呼び出して分析が必要な要件が発生することもあります。 その度にETLコードを作成してこれを管理することは多くの管理ポイントとエンジニア費用がかかります。

その意味で、S3 – OpenSearch Zero ETLは既存のOpenSearchを使用しているお客様にとっては非常に優れた機能で、お客様は簡単にデータをS3に保管し、再度呼び出すことができます。

VPC Flow LogやELB、CloutTrailなどのAWSログを従来はAthenaで構成して照会したり、OpenSearchにログを送信して分析していましたが、直接照会後クエリが可能なので便利に使えそうです。

よく使うデータはOpenSearchを使って頻繁に照会せず、必要な時だけ照会するデータはS3にロードする方法を使うと、保存費用やデータ転送費用を節約することができ、費用効率的な面でも効果があると期待されます。

AWS Clean Rooms ML

2022年のre:Inventで新しくリリースされたAWS Clean Roomsは、お客様のデータに対する環境を完全に制御し、特定の要件に合わせて指定し、データのセキュリティに対する安全な環境を提供しました。

これにより、一般的に医療や金融業界のように開発プロセスに非常に敏感なデータや規制されたデータが含まれるワークロードに適していましたが、そのサービスについて1年ぶりに今日の基調講演で新しい機能が追加されました。

この機能は、raw dataを互いにコピー及び共有することなく、MLモデルに適用することができるようになりました。

既存の機密データに対するMLモデルを使用していたワークロードが当該技術を通じて、より便利で良い性能を持ち、自分たちのデータを安全に保護することができるようになるようです。

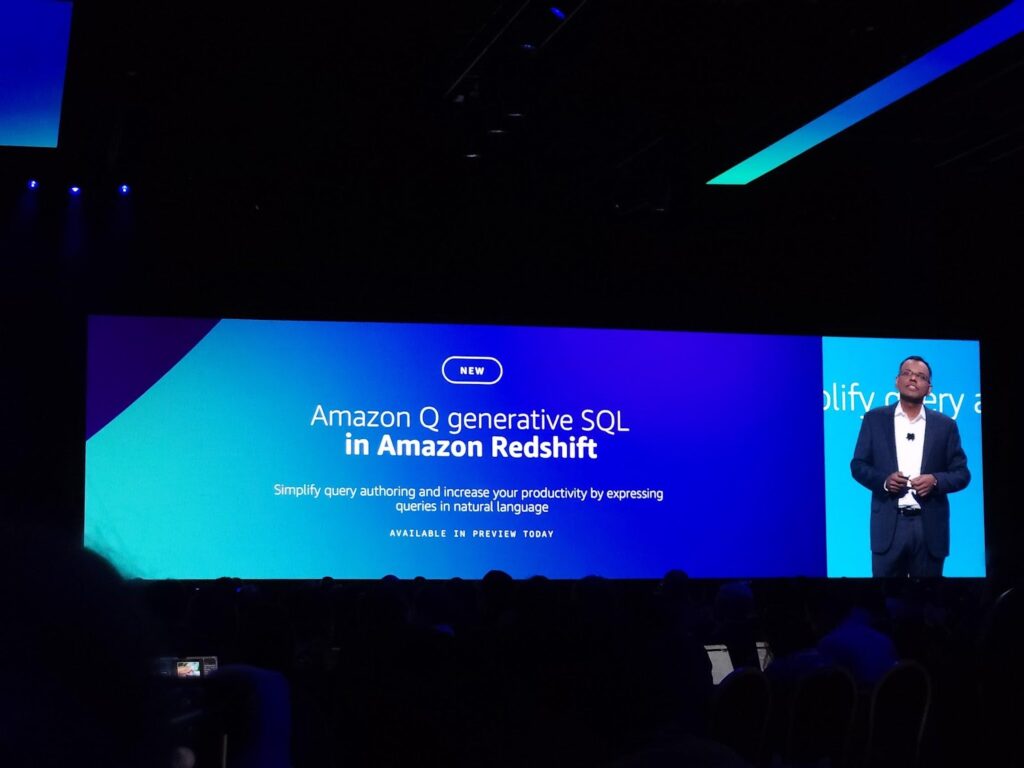

Amazon Q generative SQL in Amazon Redshift

RedshiftはAWSの代表的なDW(Data Warehouse)サービスです。そのRedshift SQL言語に対するAmazon Qのサポートは、データエンジニアリング分野で業務する方にとって非常に強力な機能の一つだと思います。

Redshiftは常に性能に比べてコストが安いサービスとして紹介されていますが、内部構造の特異点と特有のチューニングの難易度により、多くの顧客が使用に苦労しているサービスです。

これをAmazon Qを通じてSQLを提供されれば、よりRedshiftに適したクエリを簡単に提供することができ、これを通じてRedshiftの性能に対する増加も狙えます。

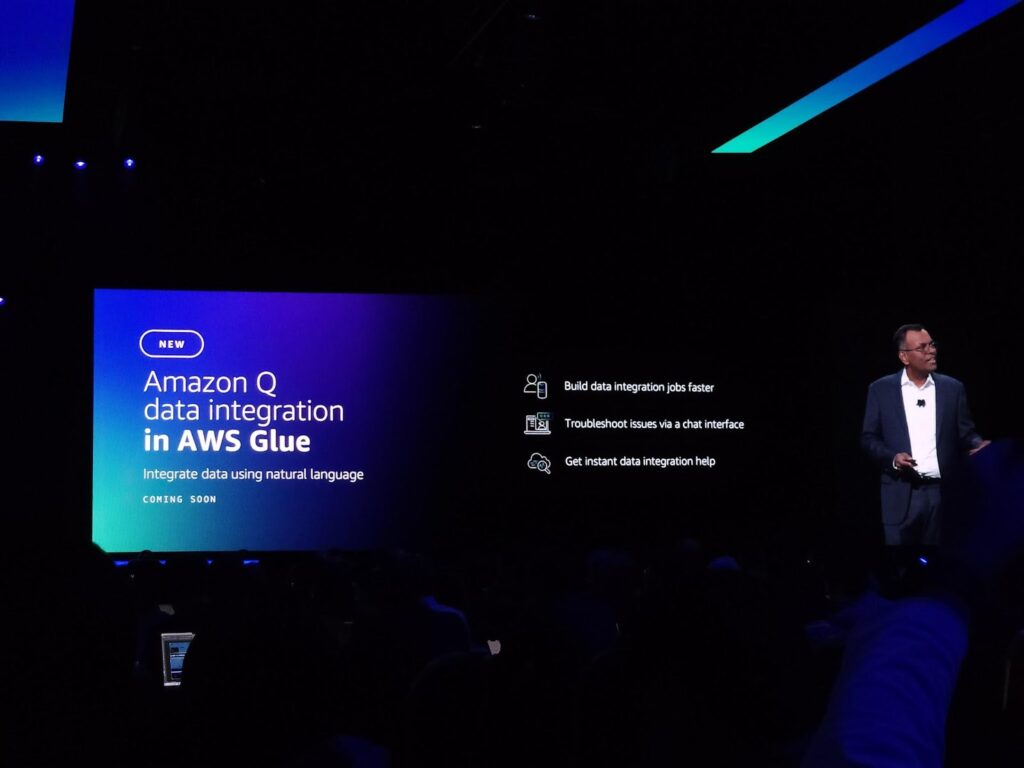

Amazon Q data integration in AWS Glue

GlueはAWSの代表的なサーバーレス分析ソフトウェアです。

お客様はGlueを使ってサーバーレス環境のETLパイプラインを構築することができます。ETLパイプラインのコードは非常にシンプルですが、複数のパイプラインを作成して管理する部分は常にデータエンジニアとして負担になる作業です。

また、よく使うコード(Source接続、Target接続)のような部分はあえてプログラマが熟達する必要がない領域である場合が多いですが、今回のAmazon QとGlueの組み合わせは、お客様のETLパイプラインの生産性向上でその効果を発揮できると思います。

Keynoteを終えて

今回紹介された新機能のうち、Amazon Titanが生成したすべての画像には目に見えない透かしが含まれています。これはAI生成画像を識別する慎重なメカニズムを提供し、誤った情報の拡散を減らすのに役立つように設計されていますが、業界初で生成した画像に対してウォーターマークを付けるように開発されたことを見て、技術の発展だけでなく、倫理的な問題まで一緒に持っていったことが印象的でした。

AI/MLの場合、データの量と質が保証されなければならないのですが、画像を意図通りに生成できるように提供され、ビジネスの方向性を固めれば、目的の画像を学習するのに大きく貢献すると思います。

MEGAZONEでは、AI/ML専門エンジニアの人材がおり、お客様のAI関連の課題を一緒にお手伝いします。今回リリースされた新機能、新技術がお客様のビジネスにどのように適用し実現可能かについて、今後も一緒に考えていきたいと思います。

注目の新規サービス

・Amazon Bedrock ANTHROPIC

・Amazon Bedrock Meta

・Amazon Titan Multimodal Embeddings

・Amazon Titan Text Lite / Titan Text Express

・Amazon Titan Image Generator

・Custom model program for Anthropic Claude

・Amazon SageMaker HyperPod

・Amazon SageMaker Innovations

・Vector engine for OpenSearch Severless

・New Vector search capabilities Amazon DocumentDB / Amazon DynamoDB

・Vector search for Amazon MemoryDB for Redis

・Amazon Neptune Analytics

・Amazon OpenSearch Service zero-ETL integration with Amazon S3

・AWS Clean Rooms ML

・Amazon Q generative SQL in Amazon Redshift

・Amazon Q data integration in AWS Glue

・Model Evaluation on Amazon Bedrock

この記事の読者はこんな記事も読んでいます

-

Compute re:Invent 2023Apple on AWS: Managing dev environments on Amazon EC2 Mac instances(Apple on AWS:Amazon EC2 Macインスタンスで開発環境を管理する)

Compute re:Invent 2023Apple on AWS: Managing dev environments on Amazon EC2 Mac instances(Apple on AWS:Amazon EC2 Macインスタンスで開発環境を管理する) -

Compute re:Invent 2023Optimizing for cost and performance with AWS App Runner(AWS App Runnerによるコストとパフォーマンスの最適化)

Compute re:Invent 2023Optimizing for cost and performance with AWS App Runner(AWS App Runnerによるコストとパフォーマンスの最適化) -

Partner Enablement re:Invent 2023Migration and modernization: Become your customer’s strategic partner

Partner Enablement re:Invent 2023Migration and modernization: Become your customer’s strategic partner